[Background]

본 논문은 아래 논문에 대한 확장 연구로 아래 연구가 Time Series Forecasting에 중점적으로 LLM을 활용한 시계열 예측 모델에 대한 LLM의 효용성에 대해서 다뤘다. 본 논문은 여기서 확장하여 Imputation, Classification, Forecasting, Anomaly Detection의 시계열 분석 분야에 대해 LLM의 필요성을 분석하였다.

https://arxiv.org/abs/2406.16964

Are Language Models Actually Useful for Time Series Forecasting?

Large language models (LLMs) are being applied to time series forecasting. But are language models actually useful for time series? In a series of ablation studies on three recent and popular LLM-based time series forecasting methods, we find that removing

arxiv.org

[Summary]

LLM 모델을 활용한 시계열 분석 모델들이 시계열 분석 분야에서 우수한 성능을 나타내는 것으로 입증되었다. 하지만 정말로 LLM이 기여한 부분이 있을까에 대한 검증이 이루어지지 않았고, 위 Background에서 언급한 논문에서도 LLM을 활용한 시계열 예측 모델들은 오히려 LLM이 없을 때 더 우수한 성능을 보이기도 한다고 주장한다. 본 논문의 저자 또한 LLM을 활용한 시계열 분석 방법에 대해서 LLM을 사용하는 것이 오히려 성능적으로 이점도 없고 자원도 많이 사용하기 때문에 사용할 필요가 없다고 주장한다. 이를 실험을 통해 검증하고자 한다.

[Experiments]

본 논문에서는 LLM을 대체하는 다양한 방법들을 사용하여 이를 검증하고자 한다.

- Random : LLM의 파라미터를 초기화하고 LayerNorm만 미세 조정하는 모델

- Linear : LLM 백본을 제거하고 단순한 Linear + LayerNorm 구조만 사용하는 모델

- Att(Attention) : LLM 백본을 제거하고 단일 Multi-head Attention layer로 대체한 모델

- Trans : LLM 백본을 단일 Transformer Encoder Layer로 대체한 모델

- NoLLM : LLM 백본을 제거하고 입력 임베딩을 바로 출력 Projection에 연결한 모델

사용한 모델은 다음과 같다.

- One-Fits-All : 시계열을 일정 구간으로 나누고 LLM에 입력

- Time-LLM : 시계열을 패치 단위로 나누고 이를 언어 토큰과 Cross-Attention으로 정렬하고 프롬프트와 함께 LLM에 입력

- CALF : 텍스트와 시계열 표현을 서로의 latent 공간으로 투사하고 두 영역의 예측을 일관성있게 맞추는 모델

- S2IP : 시계열을 성분별로 분해하고 각 성분을 유사한 의미의 텍스트 프로토타입과 정렬시켜 재구성하는 방식

시계열 데이터 분석 분야인 Imputation, Classification, Forecasting, Anomaly Detection 분야에 대해서 모두 실험을 진행하였고, 모든 결과는 논문의 Appendix에 추가되어 있다.

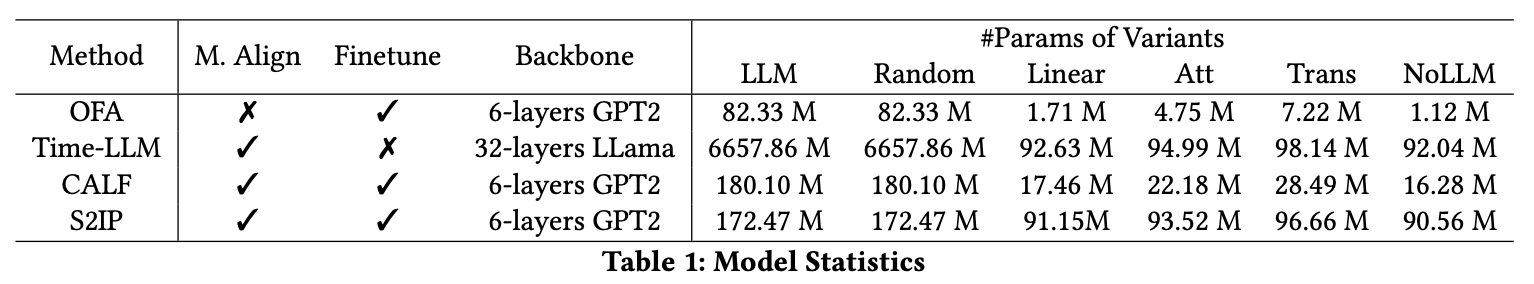

Model Statistics

총 세 가지 Research Questions 에 대한 실험을 수행한다.

- Is LLM improving performance for Time Series Modeling?

- 정말 LLM이 시계열 분석에 도움이 되는지 실험

- Can LLM effectively capture temporal dependency?

- LLM이 시계열의 시간 의존성을 탐지할 수 있는지 실험

- Is reprogramming actually aligning Time Series to Language?

- LLM을 활용한 시계열 예측 모델이 정말 Reprogramming 하고있는지 실험

Is LLM Improving Performance for Time Series Modeling?

제안한 모델의 Long Term Forecasting 을 실험하였다. 실험한 결과, One-Fits-All을 제외한 모델들은 LLM을 백본으로 사용했을 때의 이점이 전혀 드러나질 않았다. 오히려 간단한 Linear, Att, Trans 구조가 LLM과 동등하거나 더 좋은 성능을 보인다. 즉, LLM의 거대 언어 지식은 시계열 예측 성능을 실질적으로 향상시키는데 도움이 되지 않는다. 저자들은 시계열 데이터는 본질적으로 sparsity와 periodicity가 강하므로 언어 모델의 복잡한 추론 구조보다 단순한 구조가 더 적합할 수 있다고 해석한다.

Can LLM Effectively Capture Temporal Dependency?

LLM이 언어의 문맥 관계는 잘 배웠지만 그 구조가 시계열의 시간 관계도 잘 표현할 수 있는지 확인하는 실험을 진행했다.

ACF와 Durbin-Watson 통계량을 측정하여 시계열의 자기 상관을 측정하고 모델의 예측 잔차 간의 자기 상관을 검증하였다.

실험 결과, 모든 모델에 대해서 원본 시계열의 시간적 패턴을 잘 보존하지 못하는 모습을 보여주었다. 더빈 왓슨 통계값도 2에 가까워야 잘 수행되고 있다고 볼 수 있는데 모든 결과값이 2와 가깝지는 않다. 따라서 본 논문에서는 각 모델의 상대적 결과를 비교하며 LLM을 활용한 방법이 가장 0에 가까우며 이는 결국 LLM을 사용하는 모델이 가장 시간 의존성을 잘 포착하지 못 한다는 것을 의미한다.

Is Reprogramming Actually Aligning Time Series to Language?

2번 질문에 대해서 모든 모델이 시계열의 패턴을 잘 포착하지 못한다는 것이 입증되었다. 따라서 정말 제안한 모델들이 시계열과 언어 간의 Reprogramming, 즉 멀티모달 정렬을 수행하고 있는지를 검증하고자 실험을 진행하였다.

실험 결과, LLM을 사용한 모델의 UMAP Plot을 보면 Random 방식과 비교하였을 때 LLM을 사용한 방법은 시계열과 언어가 명확히 분리되지 않음을 확인할 수 있다.

결국 세 실험을 통해 현재 제안된 LLM 기반 방법들은 Temporal Dependency도 학습하지 못하고 임베딩 구조 정렬도 잘 수행되지 않음을 보인다. 따라서 저자들은 이에 대해 서로 다른 모달리티를 정렬하는 인코더가 필요하다고 주장한다.

저자들은 새로운 접근 방법으로 Mixer를 제안하는데, 자세한 방법이라기 보다는 시계열과 언어간의 정렬을 MLP를 통해서 수행되는 구조를 향후 연구로 제안하며 마무리한다.

[Results]

LLM을 활용해서 시계열 예측을 수행하는 연구가 활발히 진행되고 있는데 시계열의 특성을 고려한 설계가 쉽지 않은 것으로 보인다. VLM의 경우에는 이미지의 활성화되는 부분을 언어와 매핑시켜줌으로써 언어 임베딩과의 정렬을 이루어냈지만 시계열의 경우에는 연속적인 입력에 따라 결정되는 구조, 시간 의존성을 고려하여 언어와의 정렬을 수행해야 하기 때문에 간단하게 시계열과 언어를 정렬하려는 시도들이 pseudo alignment로만 정렬되는 것으로 보인다. 앞으로는 각 도메인의 특성을 고려한 설계 방법을 좀더 면밀히 공부해야겠다.